I chatbot di intelligenza artificiale sperimentano allucinazioni e i ricercatori di OpenAI propongono modifiche per migliorare, come rivelato in un recente rapporto.

OpenAI, un'organizzazione leader nella ricerca sull'intelligenza artificiale, ha espresso preoccupazione per la tendenza dei modelli linguistici di grandi dimensioni a generare informazioni inaccurate come se fossero fatti, un fenomeno noto come "allucinazione". In un articolo pubblicato giovedì, i ricercatori di OpenAI hanno evidenziato la causa di questo problema e proposto una soluzione per prevenirne l'accadimento.

I ricercatori sostengono che il problema principale risiede nelle attuali valutazioni basate sull'accuratezza, che premiano il "tirare a indovinare" invece di riconoscere l'incertezza. Questa disallineamento delle valutazioni incoraggia i modelli linguistici a generare risposte come se fossero sempre certi, anche quando non lo sono.

I modelli linguistici di grandi dimensioni, inclusi GPT-5 di OpenAI e Claude di Anthropic, sono sempre in "modalità test", ovvero generano risposte come se fossero valutati costantemente. Questo costante processo di valutazione porta i modelli ad imparare a indovinare, secondo OpenAI.

I tassi di rigetto di Claude, come segnalato da OpenAI, potrebbero limitare la sua utilità. Tuttavia, i ricercatori notano che i modelli di Claude sono più consapevoli della loro incertezza e spesso evitano di fare affermazioni inaccurate.

La soluzione proposta involve il ridisegno delle metriche di valutazione per impedire ai modelli di indovinare. I ricercatori suggeriscono di adattare le valutazioni primarie per evitare di penalizzare le astensioni quando si è incerti. Questo cambiamento incoraggerebbe i modelli linguistici a esprimere la loro incertezza più spesso, riducendo l'accadimento di allucinazioni.

OpenAI non ha ancora risposto a una richiesta di commento riguardo alla soluzione proposta. Tuttavia, in un post sul blog dello scorso mese, OpenAI ha spiegato che la causa dell'allucinazione nei modelli linguistici di grandi dimensioni è che i metodi di addestramento per questi modelli premiano di più il "tirare a indovinare" rispetto al riconoscere l'incertezza.

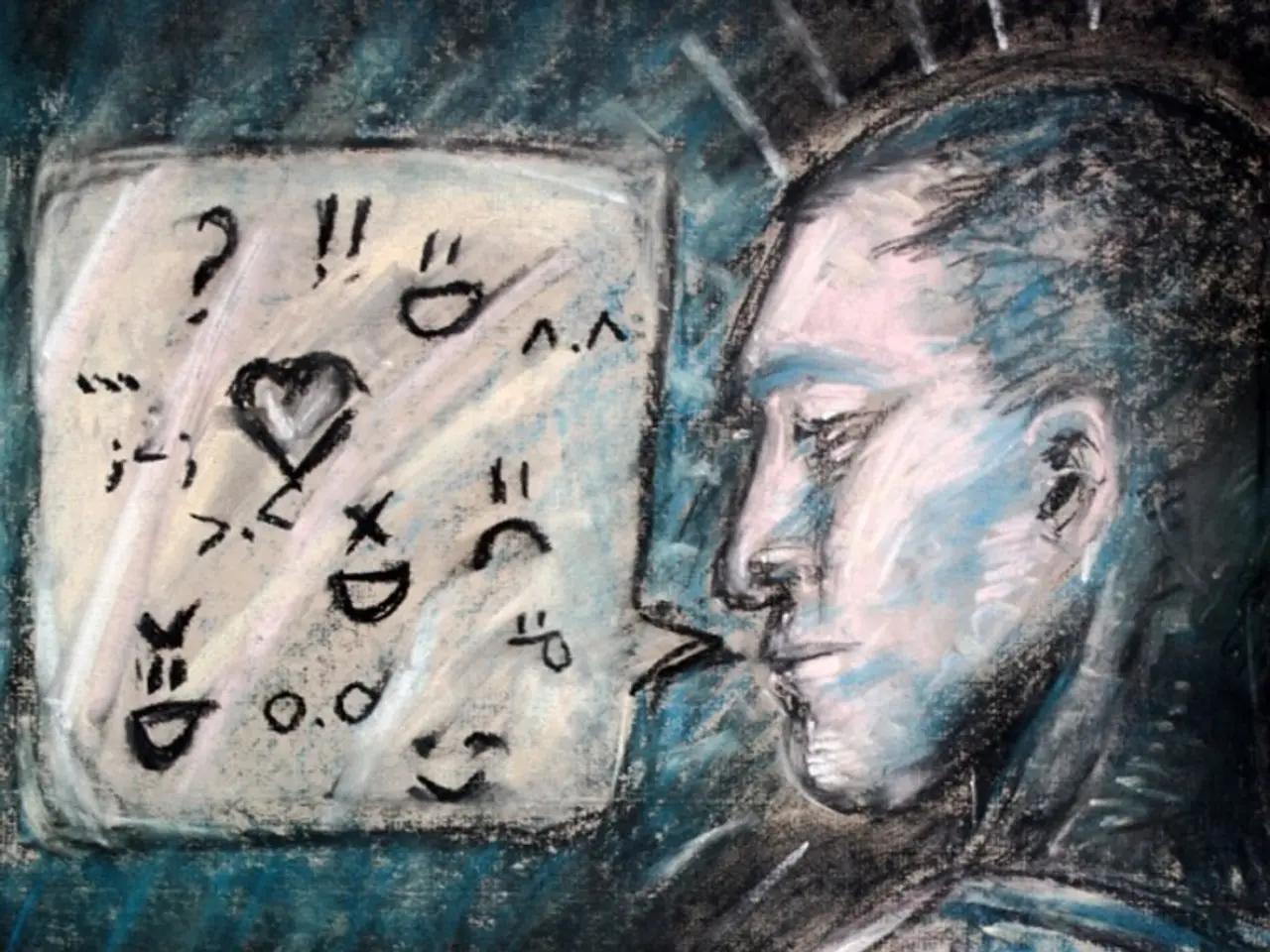

L'osservazione mostra che i modelli linguistici sono essenzialmente sempre in "modalità test", rispondendo alle domande come se tutto nella vita fosse binario - giusto o sbagliato, nero o bianco. Questo è in contrasto con il modo in cui gli esseri umani imparano il valore dell'esprimere l'incertezza fuori dalla scuola, dove l'incertezza è più comune della certezza.

Il ridisegno delle metriche di valutazione potrebbe potenzialmente migliorare l'accuratezza dei modelli linguistici, rendendoli più utili e affidabili in varie applicazioni. I ricercatori nel campo dell'intelligenza artificiale e dell'apprendimento automatico hanno proposto di riformulare le metriche di valutazione per impedire ai modelli di presentare informazioni false come fatti.

In conclusione, i risultati di OpenAI mettono in evidenza la necessità di un cambiamento nel modo in cui valutiamo i modelli linguistici. Ridisegnando le metriche di valutazione, possiamo incoraggiare i modelli linguistici a esprimere la loro incertezza più spesso, riducendo l'accadimento di allucinazioni e migliorando la loro accuratezza complessiva.

Leggi anche:

- L'orologio misterioso Cartier di fascia alta si aspetta di vendere per oltre 6 milioni di dollari all'asta autunnale

- La più importante pubblicazione sportiva portoghese A BOLA fornirà copertura esclusiva per il Summit SBC, promette contenuti sportivi di alta qualità

- Esplorare le prospettive industriali del silicio nell'economia globale!

- La pioggia ha interrotto il primo incontro di Trump con i leader tecnologici nel Rose Garden, dopo la sua decisione di pavimentare il prato bagnato per ridurre al minimo i potenziali problemi meteorologici.